После того как было покончено с ненавистным для программистов пакетным режимом и появились системы с разделением времени, первыми индивидуальными рабочими местами, подключенными к компьютерам, стали «зеленые» терминалы, прямые предшественники тонких клиентов. Они подключались к мэйнфреймам или к мини-ЭВМ. Потом, вместе с Unix, пришли Х-терминалы. Однако с началом массового производства персональных компьютеров и распространением локальных сетей выяснилось, что ПК можно использовать как рабочее место в корпоративной системе. Таких клиентов стали назвать «толстыми». А затем, в результате многолетней эволюции сложился двухполюсный мир, где множество терминальных решений разместилось на концах оси «тонкий — толстый». Средняя же часть оси до самого последнего времени оставалась незанятой, но, как выяснилось, и она весьма перспективна. У каждого из двух альтернативных подходов к клиентским местам имеются аргументы в свою пользу. В чем-то предпочтительнее тонкий, в чем-то толстый, однако то, что тонкий клиент по целому ряду эксплуатационных показателей превосходит классический персональный компьютер на рабочем месте, не подлежит сомнению. Об этом часто и вполне доказательно говорят приверженцы этого направления. Но, признавая убедительность их аргументов, нельзя не согласиться со статистикой, свидетельствующей не в пользу тонких. От общего числа рабочих мест на них приходится не более одного процента. Эта пропорция, скорее всего, предопределена тем, что ПК адекватнее природе человека, поэтому доминирующее положение ПК объективно, а не вызвано злонамеренностью определенной группы вендоров, как иногда утверждают.

После того как было покончено с ненавистным для программистов пакетным режимом и появились системы с разделением времени, первыми индивидуальными рабочими местами, подключенными к компьютерам, стали «зеленые» терминалы, прямые предшественники тонких клиентов. Они подключались к мэйнфреймам или к мини-ЭВМ. Потом, вместе с Unix, пришли Х-терминалы. Однако с началом массового производства персональных компьютеров и распространением локальных сетей выяснилось, что ПК можно использовать как рабочее место в корпоративной системе. Таких клиентов стали назвать «толстыми». А затем, в результате многолетней эволюции сложился двухполюсный мир, где множество терминальных решений разместилось на концах оси «тонкий — толстый». Средняя же часть оси до самого последнего времени оставалась незанятой, но, как выяснилось, и она весьма перспективна. У каждого из двух альтернативных подходов к клиентским местам имеются аргументы в свою пользу. В чем-то предпочтительнее тонкий, в чем-то толстый, однако то, что тонкий клиент по целому ряду эксплуатационных показателей превосходит классический персональный компьютер на рабочем месте, не подлежит сомнению. Об этом часто и вполне доказательно говорят приверженцы этого направления. Но, признавая убедительность их аргументов, нельзя не согласиться со статистикой, свидетельствующей не в пользу тонких. От общего числа рабочих мест на них приходится не более одного процента. Эта пропорция, скорее всего, предопределена тем, что ПК адекватнее природе человека, поэтому доминирующее положение ПК объективно, а не вызвано злонамеренностью определенной группы вендоров, как иногда утверждают.

Сетевой компьютер — несостоявшаяся альтернатива

Современная инсталляционная база ПК исчисляется сотнями миллионов, если не миллиардами, и предложить какую-либо альтернативу, не учитывающую предпочтения большинства, невозможно. А ведь был период, когда всерьез предпринимались попытки радикальной замены ПК, при этом главным «фокусом» было отсутствие Windows и процессоров Intel. Особое внимание к тонким клиентам привлек в ноябре 1996 года Ларри Эллисон, представив в своем сенсационном выступлении подключаемый к Internet сетевой компьютер (Network Computer, NC) как альтернативу монополии Wintel. На протяжении нескольких последующих лет он был активным проводником тонких клиентов и NC. Однажды глава Oracle даже заявил: «Эра ПК почти закончилась, начинается новая эра сетевых компьютеров». Армия сторонников Эллисона была достаточно многочисленной, к тому же она была усилена харизматичной фигурой главы Sun Microsystems Скотта Макнили. Армию противников возглавлял, естественно, Билл Гейтс: корпорация Microsoft в ответ предложила свою версию под названием NetPC. Разгорелась активная полемика, хотя прежде ни о каком противостоянии по оси «толстый — тонкий» речи не было. По прошествии времени уже не имеет значения, чем конкретно различались эти два проекта, в конечном итоге и тот и другой провалились. Неудача обусловлена в основном тем, что тогда в подавляющем большинстве случаев подключение к Сети осуществлялось по телефонным каналам, а World Wide Web даже не рассматривалась как основное приложение Internet, поэтому по возможностям оба типа устройств мало отличались от «зеленых терминалов», подключаемых к мэйнфреймам или мини-ЭВМ. В итоге, как и предполагали реалисты, победил обычный ПК.

Возврат к старой идее

Но со временем ситуация изменилась. Быстрый и безлимитный доступ в Internet стал нормой, телефонные модемы ушли в прошлое, постоянно растет стоимость обслуживания ИТ-инфраструктур. Эти обстоятельства заставляют вновь вспомнить о тонком клиенте, внимательно проанализировать аргументы десятилетней давности, к которым добавились очень серьезные требования к энергопотреблению и безопасности. Поэтому в 2006 году снова набирает силу волна интереса к тонким клиентам. Ее возникновение во многом стимулировано появлением технологий, объединенных названием Virtual Desktop Infrastructure (VDI). Оказалось, что тонкий клиент и персональный компьютер не противоречат друг другу, если ПК становится виртуальным.

Сейчас можно говорить о трех моделях организации рабочих мест.

Серверная модель. Централизованное решение, которое подразумевает доступ к приложениям с рабочих мест с использованием в том числе и тонких клиентов, через посредство специального терминального сервера. Для обмена между сервером и клиентом используются протоколы Microsoft RDP (Remote Display Protocol) или Citrix ICA (Independent Computing Architecture).

Инфраструктура виртуальных настольных систем. Также централизованное решение, но в данном случае клиент получает дистанционный доступ не к приложениям, а к удаленным рабочим станциям, работающим под управлением операционных систем Windows XP/Vista или Linux. Эти станции могут быть как виртуальными, так и физическими, размещенными на выделенных рабочих станциях-лезвиях. Клиент получает только экранную информацию. Выбор протокола определяется операционной системой, пропускной способностью канала или иными техническими требованиями; клиентские места могут быть как толстыми, так и тонкими.

Персональный компьютер. Данные могут храниться и локально, и на файловом сервере; приложения выполняются локально.

Тщательное и методичное сравнение этих моделей содержится в опубликованном отчете Application and desktop delivery advantages and disadvantages голландской аналитической компании PQR. Не меньший интерес представляет статья сотрудника корпорации Microsoft Майкла Ройстера, озаглавленная Application Deployment Architectures, The Rich versus Thin debate and beyond. Обе эти публикации датированы второй половиной текущего года. Подборку материалов на данную тему можно найти в блоге Рубена Спруджита (www.brianmadden.com).

VDI

С лета 2006 года инфраструктура VDI стала рассматриваться более узко, теперь она ассоциируется с технологиями виртуализации серверов, предлагаемыми компанией VMware, и тонкими клиентами, подключаемыми по RDP, VNC или VMware Remote Console. Вокруг этой интерпретации VDI уже сформировался альянс, включающий большинство крупных производителей– Altiris, Citrix, Fujitsu Siemens Computers, Hitachi, HP, IBM, Sun Microsystems, Wyse и др. Активность вокруг VDI вызвана тем, что этот подход имеет качественное отличие от предыдущих — он обеспечивает дистанционный доступ не к приложениям, а к оконной среде, привычной для современных пользователей.

Качественно новым в подходе VDI является то, что операционная система пользователя и его приложения продолжают существовать автономно, но размещаются не на физической, а на виртуальной машине, работающей на сервере, который находится в ЦОД компании. Доступ осуществляется с клиентского места — это может быть как ПК, так и тонкий клиент. Данная схема обеспечивает пользователю почти точно такую же возможность для работы, как если бы приложение работало на его собственном компьютере. Сочетание тонкого клиента со средой ПК, работающей на виртуальной машине, можно признать удачным компромиссом между тонким и толстым клиентами.

Централизация ресурсов решает многие эксплуатационные проблемы (устранение неисправностей, обновление программ и т.д.), возникающие на предприятии. В нынешних условиях любые затруднения в работе на ПК требуют вмешательства службы поддержки. Эта трудоемкая в стационарных условиях работа осложняется при увеличении числа мобильных сотрудником, использующих ноутбуки. По данным Gartner, в 2008 году их количество достигнет 10% от числа занятых. Централизованное управление позволяет поднять на качественно новый уровень информационную безопасность, исключает риски, связанные с потерей мобильных устройств, и устраняет проблему использования сотрудниками нелицензионного программного обеспечения.

Целесообразность VDI признана многими производителями. В нынешнем году они предлагают собственные готовые решения, различающиеся серверной средой, используемым терминальным оборудованием, сервисным программным обеспечением. Общим для всех является использование технологий виртуализации компании VMware. Впрочем, положение VMware не монопольно, есть, к примеру, компания Virtual Iron Software, предлагающая более дешевые решения, в том числе для малых и средних предприятий.

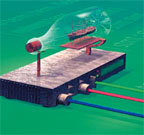

Технологии VDI фактически являются переосмыслением возможностей средств виртуализации серверов. В них прослеживаются те же самые принципы — отделение операционной системы от аппаратуры и размещение множества экземпляров операционных систем на одной машине с использованием специализированного программного промежуточного слоя, называемого гипервизором. Основное различие состоит в технологиях администрирования, используемых ресурсах и брокерах межсоединений, например, протокол RDP обеспечивает доступ к пулу ресурсов, состоящему из статически зарезервированных виртуальных рабочих мест, на которых используются реальные физические рабочие станции или тонкие клиенты (рис. 1).

Если же сравнивать VDI c серверной моделью, то для пользователя основное отличие в том, что он получает в процессе взаимодействия с сервером. При серверной модели взаимодействия пользователю предоставляется графический интерфейс к сессии терминального сервера, он получает возможность пользоваться некоторым подмножеством приложений — и только. В случае VDI дело выглядит совсем по-иному: можно создать индивидуальную для каждого пользователя среду и настроить ее в соответствии с его предпочтениями (этим как раз и подкупает ПК), пользователь может сам видоизменять эту среду, адаптировать под себя».

Для сравнения VDI с традиционными подходами предположим, что необходимо развернуть систему из нескольких сотен удаленных пользователей, занятых разработкой. Для этого можно собрать ровно такое же количество рабочих станций и установить на них программное обеспечение для дистанционного доступа. Нетрудно представить себе объем работы системных администраторов по вводу в действие и поддержанию этой системы. Если пойти по пути VDI, то все виртуальные рабочие места будут расположены в ЦОД, однако в сравнении с серверной моделью придется администрировать не один сервер и один набор приложений, а несколько сотен виртуальных машин со всеми вытекающими последствиями.

Реализация VDI

В некоторых случаях для создания инфраструктуры виртуальных настольных систем достаточно ограничиться всего одним программным продуктом VMware Virtual Desktop Manager (рис.2). На крупных предприятиях требуются более сложные инфраструктурные решения.

На рис. 3 представлено решение Virtual Desktop Infrastructure с использованием оборудования и программного обеспечения HP и VMware. Аналогичное решение от Sun Microsystems показано на рис. 4.

Преимущества VDI

Очевидно, что в представленных конфигурациях в качестве терминального устройства целесообразнее использовать ту или иную версию тонкого клиента. Разумеется, обычный ПК тоже подойдет, но тонкий клиент проще с точки зрения администрирования, надежнее с точки зрения информационной безопасности, потребляет меньше энергии и имеет более длительный жизненный цикл.

Администрирование. Тонкие клиенты не имеют дисков, устройство не хранит собственных данных, а если и хранит, то минимальный набор служебной информации, следовательно, его можно считать устройством без собственного состояния. При выходе из строя один прибор заменяется другим, как простейший настольный телефон (мобильный телефон уже имеет собственную память). Подготовка рабочего места для нового сотрудника или отключение уволившегося занимает несколько минут, поскольку все операции выполняются централизованно.

Снижение рисков. Любая компания стремится исключить потерю данных, нарушение конфиденциальности и другие риски, но распределенное хранение, наличие портативных устройств хранения (флэш-карты, диски с интерфейсом USB и т.п.) очень упрощают хищение информации, а ноутбуки могут быть потеряны или похищены. Единственный способ борьбы с этим злом — централизованное хранение данных и применение соответствующих мер защиты. Достоинство VDI заключается в том, что эти меры можно сочетать с созданием наиболее благоприятных условий для работы пользователей.

Экономия энергии. Если заменить ПК на тонкие клиенты, то в офисах, насчитывающих тысячи рабочих, суммарная экономия, включая снижение затрат на кондиционирование, может составлять сотни киловатт.

Увеличение жизненного цикла терминалов. Тонкий клиент не предполагает наличия «ломающихся» компонентов, дольше морально не стареет, поэтому его срок жизни в несколько раз больше, чем срок жизни ПК.

Тонкие ноутбуки

Возможности и перспективы VDI одними из первых осознали производители тонких клиентов. Они предложили бездисковые ноутбуки, по существу являющиеся мобильной точкой доступа к виртуальному ПК. Одной из первых оказалась Wyse, предложившая тонкие ноутбуки Wyse X90 и X90e. Это 12-дюймовые устройства, поддерживающие Bluetooth 2.0, стандарты 802.11b/802.11g и коммуникации, основанные на возможностях сотовых сетей третьего поколения. Они построены на процессоре Via C7-M ULV/1,2 ГГц, поддерживают операционную систему Windows XP и обеспечивают подключение к «базе» посредством Microsoft Windows Terminal Services, Citrix Applications Delivery или VDI. С аналогичным предложением выступила компания Neoware, ее 15-дюймовая модель m100 также не имеет никаких движущихся частей и может работать под управлением встроенной ОС Linux. Пока эти устройства занимают малую часть и без того небольшого рынка тонких клиентов, но аналитики считают его перспективным.

ПК как услуга

Завоюет ли VDI мир? То, что эта технология распространится в сегменте, где уже используются тонкие клиенты, не вызывает сомнения. Если учесть активное распространение сервисных моделей – SOA, SaaS и др., то следует предположить, что VDI открывает колоссальные перспективы поставщикам услуг связи. Если можно вместо ПК купить соответствующую услугу и с равным успехом работать с одним и тем же собственным виртуальным» ПК в любой точке земного шара, не заботясь об администрировании, обновлении, защите от вирусов, спама и т.д., то почему бы этой возможностью не воспользоваться? Есть все основания полагать, что в целом ряде случае пользователи действительно будут отказываться от реальных ПК в пользу новой версии NC, как когда-то предполагал Ларри Эллисон. При этом очевидно, что VDI — не панацея; вряд ли стоит отказываться от физических устройств там, где нужна локальная мощность.

Ну, а если заглянуть дальше, то VDI может открыть удивительные возможности для создания крупных информационных инфраструктур, скажем в образовании. Стоит ли набивать каждую школу десятками и сотнями ПК, если можно построить один ЦОД, обслуживающий целый регион? И список подобных примеров можно продолжить.

Рис. 1. Сравнение VDI и серверной модели

КПД использования ПК

Использование персональных компьютеров на рабочих местах неэкономично по двум показателям — избыточность процессорной мощности и высокое энергопотребление. По оценкам аналитиков, средняя загруженность процессоров современных офисных ПК в процессе работы не превышает 5%. Если учесть ноутбуки, которые чаще выключены, чем включены, то КПД и того меньше. Аналитики также признают, что многие приложения требуют высокой процессорной мощности и рост производительности неизбежен. Пользователям приходится обновлять свой парк техники, выводя из пользования вполне работоспособные ПК. Единственным выходом из положения является виртуализация, только она позволяет обеспечить необходимую мощность в моменты пиковых нагрузок, не раздувая общую производительность.

В среднем ПК потребляет 300-500 Вт, и если заменить физический ПК виртуальными, то, например, сервер, потребляющий 1,5-2 кВт, может удовлетворить потребности как минимум 20 пользователей. Таким образом, потребление энергии сократится на порядок.