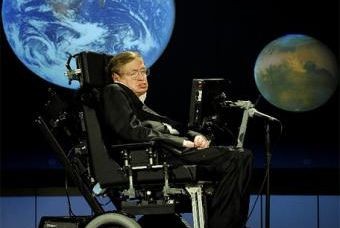

Хокинг, знаменитый физик, автор научно-популярных книг, в интервью BBC высказал мнение о том, что «разработка полноценного искусственного интеллекта может сулить конец человеческой расе».

Сегодня, по мнению Хокинга, искусственный интеллект никакой угрозы еще не несет, но в будущем ученые могут создать технику, способную превзойти людей как по мощности интеллекта, так и по физической силе.

«Подобная машина начнет жить своей жизнью и самосовершенствоваться все более быстрыми темпами, — полагает Хокинг. — Люди, чье развитие ограничено темпами биологической эволюции, будучи неспособны соперничать с подобной системой, окажутся в отстающих».

Высказывания Хокинга перекликаются с комментариями Маска, который в конце октября, выступая в Массачусетском технологическом институте, предостерег об опасностях, таящихся за исследованиями в области искусственного интеллекта.

«Думаю, с искусственным интеллектом надо быть очень осторожными, — заявил тогда Маск, генеральный директор Tesla Motors, компании — производителя электромобилей, и SpaceX — компании, занимающейся коммерческими космическими полетами. — Если бы меня спросили, какова самая серьезная угроза существованию человечества, то, наверное, это как раз искусственный интеллект. Разрабатывая его, мы вызываем демона. Во всех историях о подобном герой, изобразив пентаграмму и вооружившись святой водой, уверен, что сможет контролировать демона, но оказывается, что это не так».

Маск летом написал в Twitter, что искусственный интеллект, «наверное, еще более опасен, чем ядерное оружие», а выступая в МТИ, заявил, что разработку подобных систем необходимо проводить под строгим государственным и международным контролем.

Высказывания Маска спровоцировали жаркие споры по поводу искусственного интеллекта, хотя сегодня его уровень достаточен лишь для роботизированных пылесосов, но пока что не терминаторов, захватывающих мир.

Ясер Абу-Мостафа, профессор электронного машиностроения и компьютерных наук Калифорнийского технологического института, выразил недоумение по поводу уже начавшихся разговоров об опасности искусственного интеллекта, хотя никаких пугающих технологий еще не разработано.

«В области искусственного интеллекта не наблюдается серьезного прогресса, который бы давал основание для беспокойства, — отметил ученый. — Просто, по-видимому, стремительное развитие некоторых технических средств, например сотовых телефонов, наряду с их всеобщей доступностью дает людям основание верить в пророчества из области научной фантастики».

Маск и Хокинг, конечно, далеко не рядовые представители человечества, но ученый с ними не согласен: «Я не беспокоюсь — не только потому, что до создания машинного интеллекта высокого уровня еще, наверное, десятки лет, но и потому, что уверен — мы сможем контролировать его, когда создадим. Приведу аналогию с ядерным оружием: то, что у нас есть физическая возможность уничтожить весь мир за считанные минуты, не означает, что это произойдет. Мы предусмотрели средства, которые не позволяют это сделать».

Некоторые ученые все же не исключают возможности выхода со временем искусственного интеллекта из-под контроля человека, но считают, что подобные технологии появятся лишь через 50-100 лет, за это время вполне можно подготовить защитные меры.

«На самом деле я считаю, что подобные опасения могут иметь под собой основание, а сама вероятность создания искусственного разума, превосходящего человеческий, весьма интересна, — отметил Эндрю Мур, декан факультета компьютерных наук Университета Карнеги-Меллона. — Это опасность, которая может реализоваться лишь в отдаленном будущем, но рано или поздно о ней придется задуматься. Как только мы начнем приближаться к созданию мощных сверхразумных машин, без сомнения, необходимо будет остановиться и задуматься над тем, что мы творим».

Стюарт Рассел, профессор электронного машиностроения и компьютерных наук Калифорнийского университета Беркли, признался, что считает опасными будущие системы искусственного интеллекта, и поэтому уже сейчас организует научные дискуссии, посвященные обсуждению этой опасности. По его мнению, задумываться о данной проблеме надо уже сейчас — до того, как исследователи сумеют создать сами машины.

.jpg)