.jpg) |

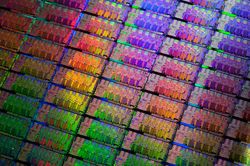

| Каждый чип проходит тщательный контроль качества с использованием сложной серии тестов. Источник: Intel |

Каждый чип, выпускаемый Intel, проходит тщательный контроль качества с использованием сложной серии тестов. В корпорации применяют технологии Больших Данных для ускорения принятия решений уже довольно давно, а в прошлом году в Intel внедрили новую платформу, состоящую из Apache Hadoop и программно-аппаратного комплекса с хранилищем данных.

С помощью новой платформы собирается информация в процессе производства и объединяются данные из ряда источников, задействовать которые раньше не представлялось возможным. Реализовавшая новшество команда всего из пяти человек в 2012 году сумела сократить стоимость тестирования линейки процессоров Intel Core на 3 млн долл.

Затем системой были охвачены и другие продукты корпорации. В Intel надеются, что в 2013-2014 году благодаря этому удастся сэкономить еще 30 млн долл. Согласно оценкам, аналитическая платформа также позволит сократить продолжительность аттестации готовых процессоров на 25%.

В поисках новых применений средств обработки Больших Данных ИТ-специалисты Intel также реализовали набор инструментов бизнес-анализа для различных подразделений корпорации; пользователи работают с этими сервисами самостоятельно.

«Мы планируем расширять применение прогнозной аналитики в сочетании с извлечением сведений из Больших Данных, — подчеркнул Крис Шоу, ИТ-директор Intel EMEA. — До недавнего времени анализ выполнялся только постфактум. Данные извлекались, помещались в базу, обрабатывались и затем генерировался ретроспективный отчет. Теперь мы получили возможность выполнять прогнозный анализ, установив на линиях тестирования чипов датчики, информация с которых обрабатывается в реальном времени».

По мнению Шоу, одна из самых больших трудностей для организаций — обработка больших объемов неструктурированных данных, поступающих из множества источников. Объединение этих данных со структурированными и извлечение полезных сведений может быть очень сложной задачей, требующей участия специалистов по анализу информации.

«На оборудование и программное обеспечение ложится задача непрерывного форматирования и обработки всего объема данных, чтобы пользователь в конечном итоге мог увидеть осмысленную информацию, а не просто поток цифр», — добавил он.

Шоу признает, что оценка окупаемости аналитической системы тоже может быть непростой задачей. Но недавнее исследование, проведенное в Массачусетском технологическом институте, показало, что компании, в которых решения принимают при помощи аналитических средств, в среднем на 5% более рентабельны, чем остальные.

Шоу рекомендует начинать с малого, чтобы доказать обоснованность дальнейших инвестиций. Сегодня команда, участвующая в проекте по оптимизации процесса контроля качества чипов, уже насчитывает 50 участников, поскольку удалось доказать высокую окупаемость инициативы.

В настоящее время Intel совместно с Apache Software Foundation строит гибридную облачную инфраструктуру на основе Hadoop. Разработчики платформы выясняют для себя, как оптимально использовать возможности процессоров Intel, а в корпорации — какие функции необходимы для поддержки Hadoop.

«Мы хотим извлечь максимум из облачных решений, — продолжил Шоу. — Если нам удастся добиться масштабной экономии благодаря взаимодействию инженерной команды с внешним разработчиком и если при этом мы сумеем предложить пользователям Hadoop то, на что они рассчитывают, значит, это и есть лучший способ добиться высокой окупаемости».

.jpg)