И это лишь один из примеров практического применения результатов реализации инициативы Project Jacquard, представленной на недавней конференции разработчиков Google I/O 2015. Исходная идея проекта — встраивание в ткань тактильных датчиков, благодаря которым одежда сможет выполнять функции сенсорного экрана. «Поскольку размеры экранов современных мобильных устройств постоянно уменьшаются, люди становятся все более ограниченными в своих возможных действиях, особенно если речь идет о носимых устройствах», – отметила Регина Дуган, глава подразделения Google Advanced Technology and Projects.

В ходе демонстрации пиджака, сшитого из умной ткани, присутствующие могли наблюдать, как человек совершает звонок со своего смартфона, дотрагиваясь до рукава собственной одежды. Однако в таком пиджаке скрываются дополнительные электронные компоненты, и пока неясно, как отразится на их функционировании проникновение в ткань жидкостей (например, при чистке или стирке).

«Идея тактильной ткани не нова, но нам хотелось бы перевести ее в практическую плоскость и сделать частью повседневной одежды», – пояснил ведущий программист Google Иван Пупырев. В настоящее время Google совместно с Levi's проектирует модели одежды, изготовленные из ткани Project Jacquard. Никакой информации о сроках поступления подобной одежды в продажу и о ее стоимости пока не сообщается.

В Google, конечно, понимают, что умная ткань может найти применение в одежде лишь в случае сотрудничества с текстильными фабриками и представителями индустрии моды. Ткань должна пройти серьезные производственные испытания, после чего потребуется наладить ее выпуск в самых разных расцветках и с разной плотностью. Google выстраивает для умной ткани целую экосистему, начиная от создания нитей и заканчивая приложениями, технологиями и сервисами, которые будут с ней взаимодействовать.

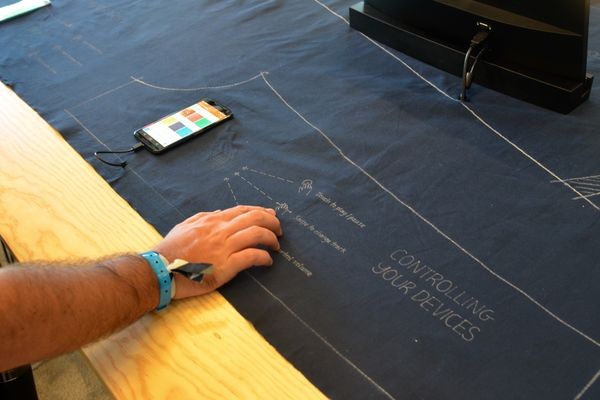

Участники конференции Google I/O имели возможность поближе познакомиться с умной тканью, напичканной электроникой, и даже потрогать ее. В ходе одной из демонстраций ткань эта использовалась для управления трехмерным изображением, выводимым на экран дисплея. На других дисплеях с ее помощью осуществлялась регулировка яркости, а на смартфонах воспроизводилась музыка.

В Google продемонстрировали также радар жестов, получивший название Project Soli и позволяющий следить за движениями руки, интерпретируя их определенным образом. Вместо того чтобы пролистывать список контактов на экране умных часов, пользователь может просто провести рукой над носимым устройством. Это движение регистрируется встроенными датчиками. Чтобы настроить громкость звучания, например, применяется жест, напоминающий набор номера на дисковом телефоне.

Конечная цель заключается в том, чтобы заменить все физические команды, требуемые для управления носимым устройством, жестами. Радар отслеживает перемещения руки в пространстве и обрабатывает их нужным образом. Google и партнеры компании реализовали весь поддерживаемый радаром функционал в одном чипе, который устанавливается в носимое устройство.

Радар способен определять расстояние и распознавать жесты. В ходе демонстрации Пупырев выставлял на цифровых часах время, держа руку на некотором удалении от устройства. Поднося руку к часам поближе и совершая жесты, напоминающие набор телефонного номера, он задавал значение часов, а отведя руку чуть подальше – минут.

Интерфейс программирования приложений (API) для радара жестов в Google обещают представить уже в этом году.

.jpg)